W kwietniu 2019 r. Grupa Ekspertów Wysokiego Szczebla ds. Sztucznej Inteligencji opracowała rekomendacje dla godnej zaufania AI. Eksperci przygotowali listę wytycznych, propozycje technicznych i nietechnicznych metod ich wdrażania, a także pilotaż ewaluacji. Grupa została powołana w związku z komunikatem Sztuczna Inteligencja dla Europy z 25 kwietnia 2018 r. W skład grupy wchodzi 52 niezależnych ekspertów, reprezentantów różnych krajów, przedstawicieli środowiska akademickiego, społeczeństwa obywatelskiego i biznesu.

W 2018 r. temat Sztucznej Inteligencji pojawił się dwukrotnie w dokumentach Komisji Europejskiej. 25 kwietnia KE opublikowała Komunikat Sztuczna Inteligencja dla Europy, a 7 grudnia Skoordynowany Plan dla Sztucznej Inteligencji. W obu dokumentach przedstawiono kluczowe obszary działalności na rzecz rozwoju Sztucznej Inteligencji:

- wzrost inwestycji (publicznych i prywatnych) w AI;

- przygotowanie na społeczno-ekonomiczne zmiany, jakie niesie rozwój AI;

- zapewnienie, że rozwój technologii odbędzie się z poszanowaniem etyki, prawa i europejskich wartości.

Kolejnym działaniem, prowadzącym do wdrożenia działań KE, było powołanie grupy niezależnych ekspertów (High-Level Expert Group on Artificial Intelligence), której zadaniem było opracowanie wytycznych etycznych dla AI i rekomendacji regulacyjnych. Dokument Ethics Guidelines for Trustworthy AI, opublikowany 8 kwietnia 2019 roku, jest realizacją pierwszej części zleconego zadania.

Rekomendacje etyczne dla godnej zaufania Sztucznej Inteligencji – Ethics Guidelines for Trustworthy AI

Celem opracowanych rekomendacji jest promowanie godnej zaufania Sztucznej Inteligencji. Zdaniem ekspertów oznacza to, że Sztuczna Inteligencja powinna być:

- zgodna z prawem (szanująca wszystkie obowiązujące przepisy prawa, zarówno na poziomie międzynarodowym, europejskim, jak i krajowym);

- etyczna (zapewniająca przestrzeganie zasad etyki i wartości);

- rzetelna (solidna, odpowiedzialna – zarówno z technicznego, jak i społecznego punktu widzenia).

Adresatem rekomendacji są wszyscy interesariusze, a więc osoby zaangażowane w projektowanie, rozwijanie, wdrażanie, wykorzystywanie AI, a także firmy, organizacje pozarządowe, naukowcy, służby, administracja państwowa i obywatele, którzy będą odbiorcami wyprodukowanych rozwiązań. Eksperci zachęcają do dobrowolnego wykorzystywania opracowanych rekomendacji w celu wspólnego działania na rzecz rozwoju godnej zaufania Sztucznej Inteligencji dla nas wszystkich.

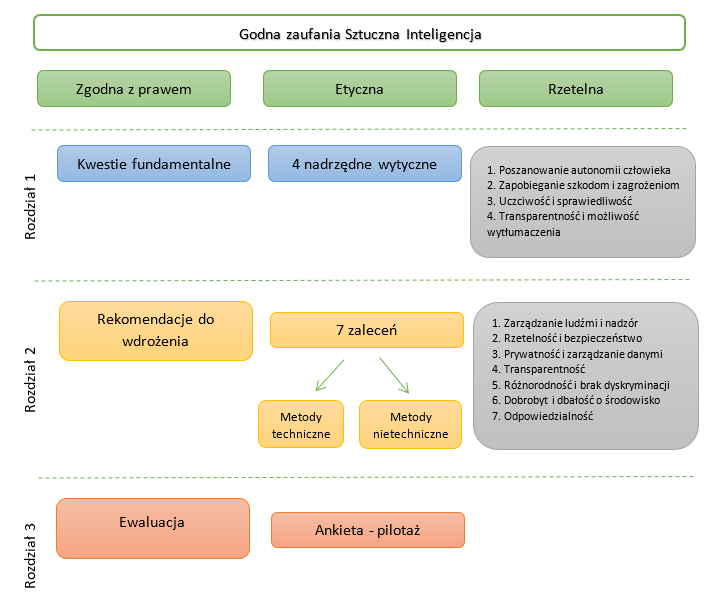

Rekomendacje podzielono na 3 rozdziały, które kolejno obejmują:

1. Kwestie fundamentalne – 4 nadrzędne wytyczne, zapewniające przestrzeganie zasad etycznych i praw podstawowych.

2. Rekomendacje do wdrożenia – 7 kluczowych zaleceń, które stanowią propozycję realizacji kwestii fundamentalnych wraz z opisem technicznych i nietechnicznych metod wdrażania.

3. Ewaluacja – próba opracowania wskaźników w formie ankiety, która może służyć do oceny wdrożonych rozwiązań z zakresu AI (rozwiązanie pilotażowe).

1. Kwestie fundamentalne

Według ekspertów Sztuczna Inteligencja powinna być rozwijana z poszanowaniem praw podstawowych, demokracji i zasad etyki. Podejście to możemy zdefiniować jako „zorientowane na człowieka”. Eksperci wyróżnili 4 wytyczne nadrzędne, które zapewniają realizację powyższych priorytetów:

1. Poszanowanie autonomii człowieka – rozwój Sztucznej Inteligencji musi zapewniać wolność i autonomię człowieka, poprzez umożliwienie użytkownikom korzystania z technologii, która nie używa manipulacji, wymuszania, czy prób wpływania na decyzje. Zamiast tego powinna być wykorzystywana w celu wzmacniania i uzupełniania zdolności poznawczych i społecznych użytkowników.

2. Zapobieganie szkodom i zagrożeniom – Sztuczna Inteligencja powinna być zaprojektowana w sposób przeciwdziałający szkodom i zagrożeniom (zarówno technicznym, jak i społecznym). Mowa tu również o sytuacjach, w których Sztuczna Inteligencja może powodować lub nasilać asymetrię władzy lub negatywnie wpływać na zrównoważony rozwój środowiska naturalnego.

3. Uczciwość i sprawiedliwość – nowoczesne technologie powinny być dystrybuowane sprawiedliwie, a więc z uwzględnieniem wszystkich grup społecznych. Oznacza to zapewnienie równego dostępu do edukacji, towarów i usług, a także samej technologii. Ważne, aby Sztuczna Inteligencja w żaden sposób nie prowadziła do ograniczenia wolności wyboru.

4. Transparentność i możliwość wytłumaczenia – godna zaufania Sztuczna Inteligencja musi być wyjaśnialna i transparentna. Konieczna jest wiedza o algorytmach i sposobie podejmowania decyzji przez system, a także możliwość dotarcia do takiej wiedzy dla użytkowników danej technologii.

2. Rekomendacje do wdrożenia

Eksperci poza opracowaniem wysokokontekstowych wytycznych, przygotowali listę siedmiu bardziej konkretnych zaleceń, które stanowią realizację kwestii fundamentalnych, a także techniczne i nietechniczne metody ich wdrożenia. Lista nie jest zamknięta.

Zarządzanie ludźmi i nadzór

Systemy Sztucznej Inteligencji powinny wspierać procesy podejmowania decyzji, a także zarządzanie ludźmi z poszanowaniem praw podstawowych człowieka, demokracji i sprawiedliwości społecznej.

Rzetelność i bezpieczeństwo

Technologie muszą być opracowane w sposób rzetelny i bezpieczny tak, aby z wyprzedzeniem diagnozować możliwe ryzyka, a także zapobiegać szkodom. Konieczne jest prewencyjne podejście i przewidywanie wystąpienia nie tylko zamierzonych, ale również niezamierzonych szkód.

Prywatność i zarządzanie danymi

Sztuczna Inteligencja powinna szanować prywatność, a tym samym w sposób odpowiedzialny zarządzać i przetwarzać dane tak, aby chronić prywatność użytkowników.

Transparentność

Transparentność powinna być zapewniona na trzech płaszczyznach:

- transparentność danych – sposób zbierania i przetwarzania danych, a także sposób działania algorytmów;

- transparentność systemów – możliwość prześledzenia technicznej architektury systemu i zrozumienia jego działania;

- transparentność komunikacji – prawo do informacji, że komunikacja odbywa się z użyciem Sztucznej Inteligencji, a także wyższość komunikacji międzyludzkiej nad komunikacją z maszyną.

Różnorodność i brak dyskryminacji

Ważne, aby zasada różnorodności była brana pod uwagę w całym cyklu życia systemu Sztucznej Inteligencji, z uwzględnieniem potrzeb wszystkich zainteresowanych stron. W tej rekomendacji zawarte jest również przeciwdziałanie wykluczeniu i zapewnienie równego dostępu do technologii wszystkim grupom społecznym.

Dobrobyt i dbałość o środowisko

Sztuczna inteligencja powinna działać na rzecz dobrobytu ludzkości, a także z uwzględnieniem dbałości o zrównoważony rozwój i środowisko naturalne. W ramach tej rekomendacji zawiera się zasada zapobiegania szkodom i możliwym ryzykom.

Odpowiedzialność

Zdaniem ekspertów ktoś powinien być odpowiedzialny za systemy Sztucznej Inteligencji i ich działanie. Oznacza to również możliwość przeprowadzenia oceny działania algorytmów i procesów. Ocena powinna być dokonywana przez audytorów i nie musi być jawna. W przypadku aplikacji krytycznych dla bezpieczeństwa ważne, aby umożliwić człowiekowi niezależne kontrolowanie maszyny w każdym momencie.

Metody wdrażania rekomendacji

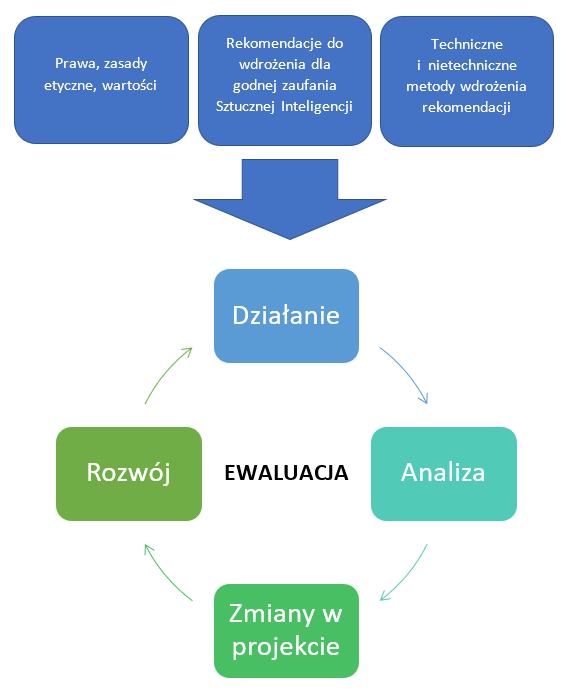

Wdrożenie powyższych zaleceń może

być przeprowadzone z pomocą metod technicznych albo nietechnicznych, które

obejmują wszystkie etapy cyklu życia systemu Sztucznej Inteligencji. Warto

zwrócić uwagę, że ze względu na ciągłe ewoluowanie systemów AI, realizacja

zadania jest procesem ciągłym. Oznacza to, że na każdym etapie należy weryfikować

poprawność wdrożonych zaleceń.

Zaproponowane metody są jedynie sugestią, mogą być wzajemnie komplementarne lub alternatywne.

Metody techniczne:

- Architektura systemu – uwzględnienie zaleceń etycznych w architekturze systemu np. poprzez stworzenie zestawu reguł tzw. „białej listy” i „czarnej listy”.

- Ethics and rule of law by design – wdrażanie rozwiązań gwarantujących przestrzeganie prawa i etyki już na etapie projektowania Sztucznej Inteligencji.

- Metody wyjaśniające – zastosowanie metod umożliwiających prześledzenie procesu podejmowania decyzji przez algorytmy.

- Testy – sprawdzenie systemu pod kątem wystąpienia zagrożeń, a także ocena ryzyka naruszenia prawa lub zasad etyki.

- Kontrola jakości – włączenie kwestii etycznych do kryteriów jakości systemu.

Metody nietechniczne:

- Regulacje – wdrażanie istniejących regulacji, np. powyższych rekomendacji. Zalecenia inwestycyjne i na poziomie „policy” zostaną opracowane przez ekspertów w kolejnym dokumencie.

- Kodeks postępowania – przedsiębiorstwa mogą opracować wewnętrzne kodeksy postępowania lub własne wskaźniki KPI, które będą służyć zapewnieniu wysokiego poziomu etyki w projektowanych systemach.

- Standaryzacja – standardy mogą funkcjonować jako wsparcie dla systemów zarządzania jakością w Sztucznej Inteligencji i stanowić zachętę dla producentów. W przyszłości można opracować odpowiednie oznaczenia/etykiety, np. „godna zaufania Sztuczna Inteligencja”.

- Certyfikacja – stworzenie systemu, dzięki któremu możliwe będzie zdobycie poświadczenia, że dany system AI jest odpowiedzialny, sprawiedliwy i godny zaufania.

- Odpowiedzialność za kwestie etyczne – firmy mogą w ramach wewnętrznych struktur powołać osoby, które będą odpowiedzialne za wdrożenie wytycznych etycznych w systemach sztucznej Inteligencji.

- Edukacja i wzrost świadomości – konieczna jest praca na rzecz edukacji i budowy świadomości dotyczącej kwestii etycznych w nowoczesnych technologiach. Taka wiedza powinna być przekazywana zarówno projektantom rozwiązań, osobom zarządzającym, jak i użytkownikom.

- Współpraca interesariuszy – ważne, aby kwestie etyczne w Sztucznej Inteligencji były omawiane w szerokim gronie wszystkich interesariuszy: techników, inżynierów, ekspertów, etyków, decydentów, przedstawicieli wszystkich grup społecznych, w tym również konsumentów.

- Różnorodność – zespoły, które zajmują się projektowaniem rozwiązań z zakresu Sztucznej Inteligencji powinny być różnorodne i reprezentować ogół społeczeństwa.

3. Ewaluacja

Eksperci opracowali wskaźniki, które umożliwiają ocenę wdrożonych rozwiązań z zakresu godnej zaufania Sztucznej Inteligencji. Ankieta zawiera pytania skierowane zarówno do managementu, zespołów HR, zespołów odpowiedzialnych za jakość, IT, jak i do operatorów danego rozwiązania. Opracowana wersja jest pilotażowa i będzie weryfikowana we współpracy z różnorodnymi interesariuszami z sektora publicznego i prywatnego w badaniach jakościowych i ilościowych. Ostateczna wersja zostanie opublikowana w 2020 r.

Grupa ekspertów Wysokiego Szczebla ds. Sztucznej Inteligencji zaprasza wszystkie zainteresowane strony do wzięcia udziału w konsultacji rozwiązania.

Podsumowanie:

- W związku z opublikowanym 25 kwietnia komunikatem KE Sztuczna Inteligencja dla Europy, Komisja powołała Grupę Ekspertów Wysokiego Szczebla ds. Sztucznej Inteligencji. W skład grupy wchodzi 52 niezależnych ekspertów, reprezentantów różnych krajów, przedstawicieli środowiska akademickiego, społeczeństwa obywatelskiego i biznesu.

- Rekomendacje Grupy ekspertów Wysokiego Szczebla ds. Sztucznej Inteligencji wpisują się kluczowe obszary działalności KE na rzecz rozwoju Sztucznej Inteligencji: wzrost inwestycji w AI; przygotowanie na zmiany społeczne i technologiczne, jakie niesie AI; a także rozwój technologii z poszanowaniem praw, wartości i zasad etycznych.

- W wyniku prac grupy, eksperci przygotowali rekomendacje, które mają się przyczynić do rozwoju godnej zaufania Sztucznej Inteligencji: zgodnej z prawem, etycznej i rzetelnej.

- Rekomendacje zostały opracowane w 3 rozdziałach, które kolejno odnoszą się do wysoko-kontekstowych kwestii fundamentalnych, gotowych do wdrożenia zaleceń i wskaźników oceny aktualnych rozwiązań AI. Raport grupy ekspertów jest pierwszym tego typu dokumentem, który poza opracowaniem ogólnych rekomendacji przedstawił propozycje ich wdrożenia, a także wskaźniki umożliwiające ocenę.

- Przedstawione wskaźniki oceny są wersją pilotażową, która zostanie poddana ewaluacji. Wyniki zostaną opublikowane w 2020 r.