W dniu 7 października 2021 roku Komisja Europejska przedstawiła wyniki szóstej oceny wdrożenia Kodeksu postępowania UE w sprawie przeciwdziałania mowie nienawiści w Internecie (ang. The EU Code of conduct on countering illegal hate speech online).

Kodeks będący wspólnym przedsięwzięciem KE oraz największych przedsiębiorstw z branży technologicznej został przedstawiony w 2016 roku. KE we współpracy z organizacjami z państw członkowskich UE przeprowadza testy sprawdzające, w jakim stopniu sygnatariusze Kodeksu realizują zobowiązania zawarte w Kodeksie.

Kontekst

Jednym z głównych dokumentów, który wyznaczył kierunek działań UE wobec mowy nienawiści jest Decyzja ramowa w sprawie zwalczania rasizmu i ksenofobii (Decyzja ramowa Rady 2008/913/WSiSW z dnia 28 listopada 2008 r. w sprawie zwalczania pewnych form i przejawów rasizmu i ksenofobii za pomocą środków prawnokarnych, ang. Framework Decision on Combating Racism and Xenophobia). Zobowiązuje ona państwa członkowskie do zapewnienia karalności m.in. publicznego, w tym także mającego miejsce w Internecie, nawoływania do nienawiści lub przemocy na tle rasowym, religijnym czy etnicznym.

Przedstawienie Kodeksu postępowania UE w sprawie przeciwdziałania mowie nienawiści w Internecie stanowiło kolejny ważny krok na drodze zwiększenia bezpieczeństwa użytkowników Internetu. Podstawą prawidłowego funkcjonowania Kodeksu jest wzajemna współpraca unijnej administracji i przedstawicieli przedsiębiorstw z branży technologicznej, którzy spotykają się w ramach Unijnej Grupy Wysokiego Szczebla ds. Zwalczania Rasizmu, Ksenofobii i Innych Form Nietolerancji (ang. EU High Level Group on combating racism, xenophobia and other forms of intolerance).

Rezultaty szóstej oceny wdrożenia Kodeksu postępowania UE w sprawie przeciwdziałania mowie nienawiści w Internecie

Aktualna ocena wdrożenia Kodeksu postępowania trwała 6 tygodni (od 1 marca do 14 kwietnia 2021 r.). W proces oceny wdrożenia Kodeksu zaangażowało się 35 organizacji z 22 państw członkowskich UE.

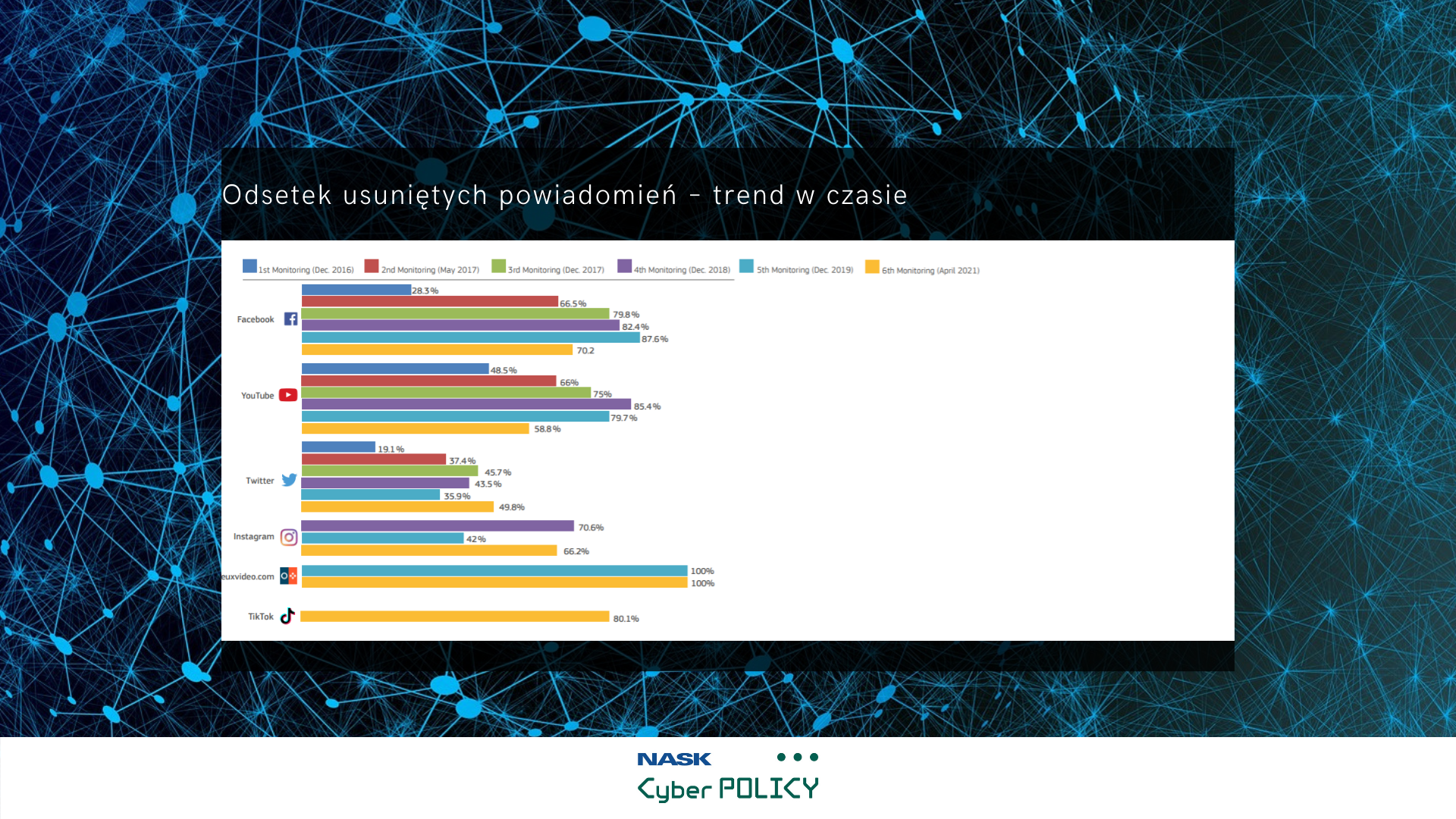

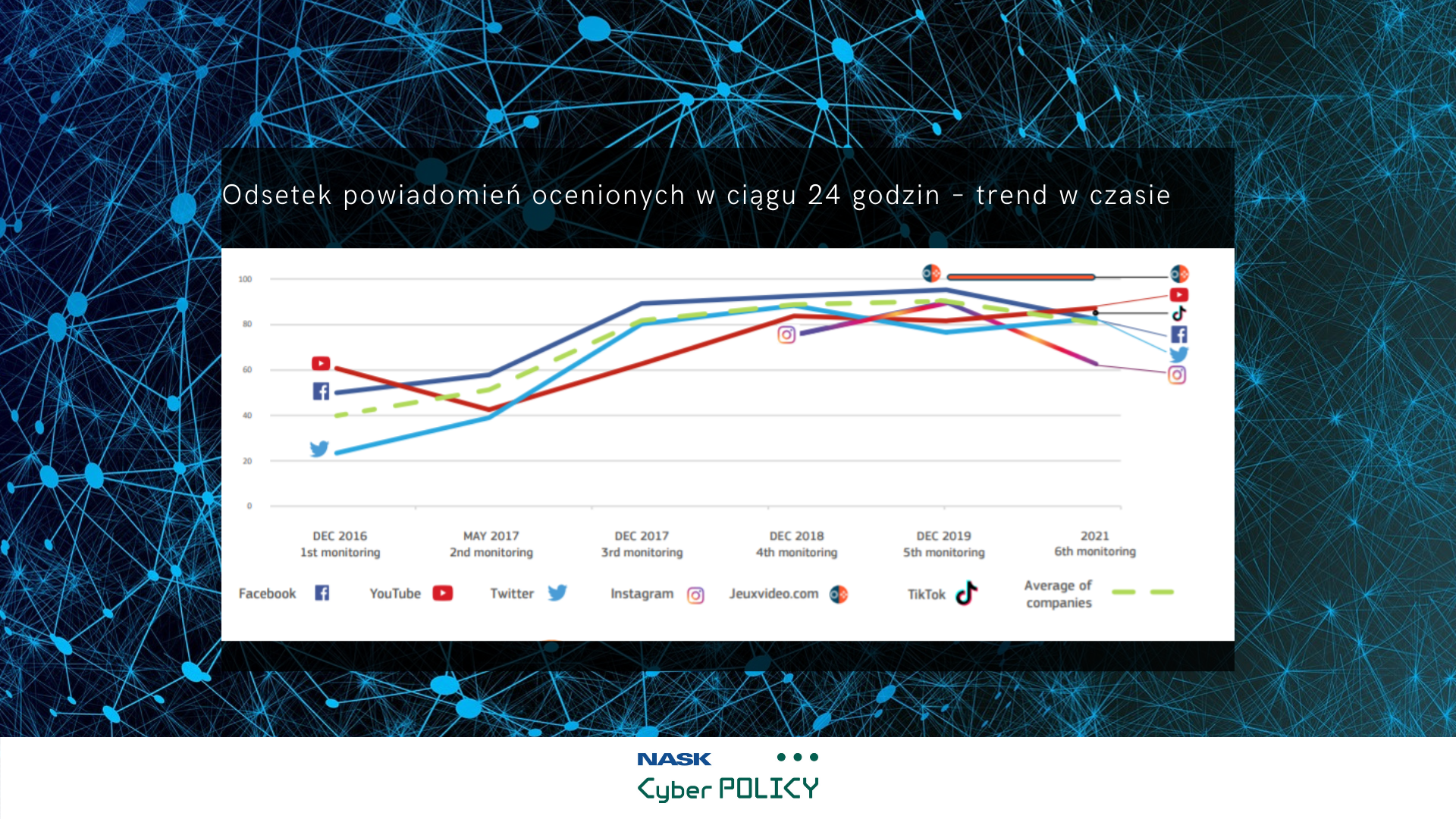

Jak wynika z raportu KE spośród 4543 przesłanych zgłoszeń dotyczących nielegalnej mowy nienawiści sygnatariusze Kodeksu w ciągu 24 godzin zareagowali na 81% zgłoszeń i usunęli 62,5% z nich. Warto podkreślić, że skuteczność sygnatariuszy Kodeksu była niższa niż w roku 2020 i 2019. W związku z tym, podobnie jak w latach poprzednich, główną słabością systemu zapobiegania mowie nienawiści w Internecie pozostaje niewystarczające reagowanie na zgłoszone przez użytkowników podejrzane lub niewłaściwe treści. W tym roku mowa nienawiści w Internecie była ukierunkowana głównie wobec mniejszości seksualnych (18,2%), wynikała z ksenofobii (18%) lub była skierowana w stosunku do ludności romskiej (12,5%).

Procentowy spadek wobec ubiegłorocznej oceny zanotowano także w odniesieniu do usuwania mowy nienawiści w dwóch kategoriach. W 2021 roku usunięto 69% treści nawołujących do zabicia lub stosowania przemocy wobec określonej grupy, podczas gdy w 2020 roku udało się to w przypadku 83,5% treści. Podobnie było w przypadku mowy nienawiści zawierającej słowa, sformułowania lub obrazy zniesławiające daną grupę – usunięto 55% wobec zeszłorocznych 57,8%.

Działania wybranych podmiotów z sektora mediów społecznościowych

Do zmian względem poprzednich ocen zaliczyć można wdrażanie przez podmioty konkretnych mechanizmów i metod przeciwdziałania mowie nienawiści, w tym także zwiększenie roli zautomatyzowanych procesów. Informacje w tym zakresie zostały dostarczone przez 5 platform społecznościowych: YouTube, TikTok, Twitter oraz Facebook/Instagram. Wspólnym punktem wszystkich serwisów jest określanie treści niedopuszczalnych w dokumentach takich jak zasady społeczności lub zasady użytkowania.

Polityka serwisu YouTube opiera się zarówno o zgłoszenia użytkowników oraz zautomatyzowane procesy. Według informacji dostarczonych przez platformę, pomiędzy styczniem a marcem bieżącego roku za naruszenie przepisów dotyczących zapobiegania mowie nienawiści usunięto ponad 85 tyś filmów, z czego 76% zostało usuniętych zanim miały 10 odsłon, a także 43,6 miliona komentarzy. Procedura usuwania zawartości zakłada także możliwość odwołania się od decyzji serwisu. Dodatkowo w tym okresie sprawozdawczym usunięto ponad 15 tyś filmów zawierających naruszenia zasad przeciwdziałania mowie nienawiści, a które zostały przesłane z adresów IP w Europie.

TikTok wykorzystuje połączenie rozwiązań technologicznych (autonomicznych) oraz moderację treści. Po zidentyfikowaniu mowy nienawiści, niezależnie czy to wideo czy komentarz, zawartość jest usuwana. Serwis deklaruje, że organizowane są szkolenia dla zespołów moderujących treści w celu zwiększenia ich zdolności do identyfikowania zachowań, symboli, określeń i stereotypów noszących znamiona mowy nienawiści. Na portalu TikTok, tak jak w przypadku YouTube, istnieje możliwość odwołania się od decyzji o usunięciu treści. Serwis podaje, że w pierwszym kwartale 2021 roku usunięto około 62 milionów filmów na całym świecie, z czego 2% naruszało zasady dotyczące zakazu publikowania mowy nienawiści. Z tego, według TikTok, 67% treści zostało usuniętych z inicjatywy serwisu, zanim zostały zgłoszone przez użytkowników, a 84% wideo zniknęło w ciągu 24 godzin od opublikowania.

Serwis Twitter wyraźnie określa jakiego typu treści lub zachowania są niedozwolone w swoich zasadach. W zakresie ochrony przed niepożądaną zawartością, w tym mową nienawiści, deklaruje że ponad 50% działań jest podejmowana proaktywnie, z inicjatywy portalu m.in. poprzez wykorzystanie rozwiązań z zakresu uczenia maszynowego. Ponadto podejmowane są działania mające na celu zwiększenie transparentności zawartości publikowanej na Twitterze oraz wspieranie rozpowszechniania prawdziwych informacji. W tym obszarze portal wdraża rozwiązania dotyczące oznaczania postów, które mogą zawierać nieprawdziwe lub wprowadzające w błąd informacje. W zakresie rozwiązań ukierunkowanych przeciwko mowie nienawiści, w ciągu ostatnich 12 miesięcy Twitter uaktualnił przepisy Zasad dotyczących zachowań przepełnionych nienawiścią w celu rozszerzenia ochrony użytkowników przed staniem się ofiarami. Według statystyk portalu pomiędzy styczniem a czerwcem 2020 roku zanotowano:

- 34% spadek liczby kont, wobec których zastosowano sankcje wynikające z zasad dotyczących przeciwdziałania nękaniu oraz

- 35% spadek liczby kont, wobec których zastosowano sankcje wynikające z zasad dotyczących przeciwdziałania mowie i zachowaniom nawołującym do nienawiści.

Ogółem w tym samym okresie sprawozdawczym w obu powyższych kategoriach podjęto łącznie działania wobec ponad miliona użytkowników lub treści na nich opublikowanych, z czego zablokowano ponad 200 tyś kont. Łącznie usunięto ponad 1,5 miliona treści (postów, zdjęć, opisów kont) naruszających zasady serwisu Twitter.

W serwisach Facebook i Instagram, zgodnie z przekazanymi informacjami, około 95% treści zawierających mowę nienawiści jest wykrywana proaktywnie, z inicjatywy portali. Niepożądane treści wykrywane są z wykorzystaniem rozwiązań z zakresu sztucznej inteligencji, która jest także używana do wyjaśniania i nadawania priorytetu bardziej poważnym lub skomplikowanym przypadkom. Statystyki za drugi kwartał 2021 roku opublikowano z podziałem działania podejmowane w każdym z poszczególnych serwisów: Facebook i Instagram.

Na Facebooku zidentyfikowano 31,5 miliona treści noszących znamiona mowy nienawiści, w porównaniu do 25,2 miliona z pierwszego kwartału bieżącego roku. 97,6% z nich zostało zidentyfikowanych przez serwis, zanim zostały zgłoszone. Dodatkowo zidentyfikowano 6,2 miliona zawartości określanej jako zorganizowana mowa nienawiści, wobec 9,8 miliona z poprzedniego kwartału. 97,8% z nich było wykrytych proaktywnie. Odnotowano 1,4 miliona skarg na usunięcie treści przez Facebook, w wyniku czego 88,1 tyś treści zostało przywróconych po ich pierwotnym usunięciu. Według serwisu drugi kwartał 2021 roku był trzecim z kolei, w którym spadła tak zwana powszechność mowy nienawiści na Facebooku i jest na poziomie 0,05%. Oznacza to, że na 10 tyś odsłon treści portalu 5 zawiera mowę nienawiści.

Na Instagramie podjęto działania wobec 9,8 milionów treści zidentyfikowanych jako mowa nienawiści, co oznacza wzrost wobec 6,3 miliona z pierwszego kwartału 2021 roku. 95,1% z nich zostało zidentyfikowanych przez serwis, zanim zostały zgłoszone. Tak zwanej zorganizowanej mowy nienawiści usunięto 367 tyś w porównaniu do 325 tyś w pierwszym kwartale. 77,7% z nich było wykrytych proaktywnie. Brak jest danych odnośnie liczby skarg i przywróconych treści w serwisie Instagram, z uwagi na ograniczoną efektywność procedury oceny zasadności skarg w wyniku ograniczeń spowodowanych pandemią COVID-19.

Dalsze działania

Zdaniem V. Jourovej i D. Reyndersa kolejnym znaczącym etapem walki z mową nienawiści w Internecie będzie wdrożenie Aktu o usługach cyfrowych (ang. Digital Services Act, DSA). DSA zawiera zestaw zasad i zobowiązań dla podmiotów świadczących usługi w sektorze IT, w tym mediów społecznościowych. Warto podkreślić, że DSA zawiera także rozwiązania i ramy prawne do zwalczania nielegalnych treści w Internecie. Wdrożenie DSA będzie wymagało także dokonania zmian w Kodeksie postępowania, w związku z nowymi obowiązkami nakładanymi na przedsiębiorstwa z sektora IT.

Niezależnie od projektowanych przepisów DSA, KE zachęca przedstawicieli biznesu z branży technologicznej do podejmowania współpracy oraz nawiązania relacji z organizacjami społecznymi i obywatelskimi w celu zwiększenia efektywności w reagowaniu na zgłoszenia użytkowników.

Podsumowanie:

- Szósta ocena wdrożenia Kodeksu postępowania trwała od 1 marca do 14 kwietnia 2021 r. W proces oceny wdrożenia Kodeksu zaangażowało się 35 organizacji z 22 państw członkowskich UE.

- Spośród 4543 przesłanych zgłoszeń dotyczących nielegalnej mowy nienawiści sygnatariusze Kodeksu w ciągu 24 godzin zareagowali na 81% zgłoszeń i usunęli 62,5% z nich. Skuteczność sygnatariuszy Kodeksu w tym obszarze była niższa niż w roku 2020 i 2019.

- Procentowy spadek wobec ubiegłorocznej oceny zanotowano także w odniesieniu do usuwania mowy nienawiści w dwóch kategoriach. W 2021 roku usunięto 69% treści nawołujących do zabicia lub stosowania przemocy wobec określonej grupy, podczas gdy w 2020 roku udało się to w przypadku 83,5% treści. Podobnie było w przypadku mowy nienawiści zawierającej słowa, sformułowania lub obrazy zniesławiające daną grupę – usunięto 55% wobec zeszłorocznych 57,8%.

- Kolejnym znaczącym etapem walki z mową nienawiści w Internecie będzie wdrożenie Aktu o usługach cyfrowych (ang. Digital Services Act, DSA), który zawiera m.in. rozwiązania i ramy prawne do zwalczania nielegalnych treści w Internecie.